パブリックデータから経路リークを探る

2017/08/25 12:30 (JST) ごろ、日本国内で大規模な通信障害が観測されました。

通信障害の内容について、とても詳細にまとめられている記事があります。

障害の内容はさておき、このエントリでは障害のしくみについて探ってみようと思います。

MRT Dump から見るBGP Update 数の急増

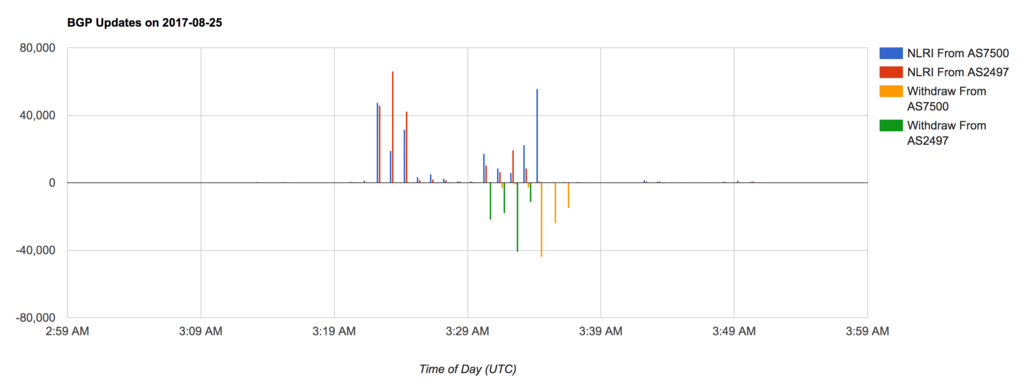

MRT Dump をもとに、該当時刻のBGP Update 数(毎分) をバーチャートにしました。

- 横軸: 時刻(UTC)

- 縦軸: BGP Update されたのべPrefix 数

- 正: NLRI

- 負: Withdraw

単純にBGP Update の回数をカウントしているため、Path Attribute だけの変更だったり、NLRI → Withdraw → 同じNLRI の場合でも すべて1回と数えています。

普段と比べるとUpdate 数が激増している期間があります。03:23 ~ 03:35 (UTC) の間です。

報道によれば「8分以内に正しい情報に修正した」とのことですが、実際にはすぐにBGP Update が収束しているわけではなさそうで、AS2497 からの経路変化でみると 発生(03:23) ~ 収束(03:34) とすこし時間幅が大きくなっています。これはおそらく経路を仲介しているAS の設計に依存し、MRAI などで伝搬を遅延させる影響を受けていると考えられます。

意図せずトランジットされた経路数はおよそ10万経路。直接の影響を受けたASは3000程度。また、通信先がこの吸い込みに影響されていた場合には直接影響のあったASではなくても多くの利用者がおかしいなあと思ったはず

— Yoshinobu Matsuzaki (@maz_zzz) 2017年8月25日

トータルでおおよそ10万経路が影響を受けていることは、MRT Dump からも観測できます。

route_leak=# SELECT count(DISTINCT prefix) FROM updates WHERE ix='wide' AND neighbor_as=2497 AND time > '2017-08-25 03:23'::TIMESTAMP AND time < '2017-08-25 03:35'::TIMESTAMP; count -------- 114965 (1 row)

経路の急増が引き起こす問題

現在 IPv4 経路数はおおよそ70万弱とされているため、フルルートが一時的に 70万→80万 に増加したことになります。運悪くちょうどRIB / FIB キャパシティが限界を迎えることは十分ありえます。

この影響により、バックボーンルーター(ISP間など上位ネットワークで通信を行う装置)が、全体的に高負荷な状況に陥り、結果として16:16頃、弊社サーバー群と繋がるバックボーンルーターの一部が停止いたしました

http://hiroba.dqx.jp/sc/news/detail/a495eebbfa243b79c5b9b224c482d0c2/

限界値はさまざまですが、

どちらの場合もルーターが不安定になったり、あるネットワークに通信できなくなったりします。

これは問題の原因のひとつと思われますが、これにあたった事業者はおそらく少数なのでは?と想像しています。

経路の中身は?

次のテーブルは観測されたAS_PATH の一例です。一部報道のとおり、AS15169 (Google) が経路をトランジットしているのがわかります。

route_leak=# SELECT aspath, count(distinct prefix) FROM updates WHERE ix='wide' AND neighbor_as=2497 GROUP BY aspath ORDER BY count DESC LIMIT 10; aspath | count ---------------------------+------- 2497 701 15169 4713 | 24831 2497 701 15169 7029 | 7308 2497 701 15169 8151 | 4639 2497 701 15169 9121 | 4606 2497 701 15169 9264 1659 | 3014 2497 701 15169 9394 | 2129 2497 701 15169 3209 | 1757 2497 701 15169 7303 | 1580 2497 701 15169 4230 28573 | 1475 2497 701 15169 7545 | 1420 (10 rows)

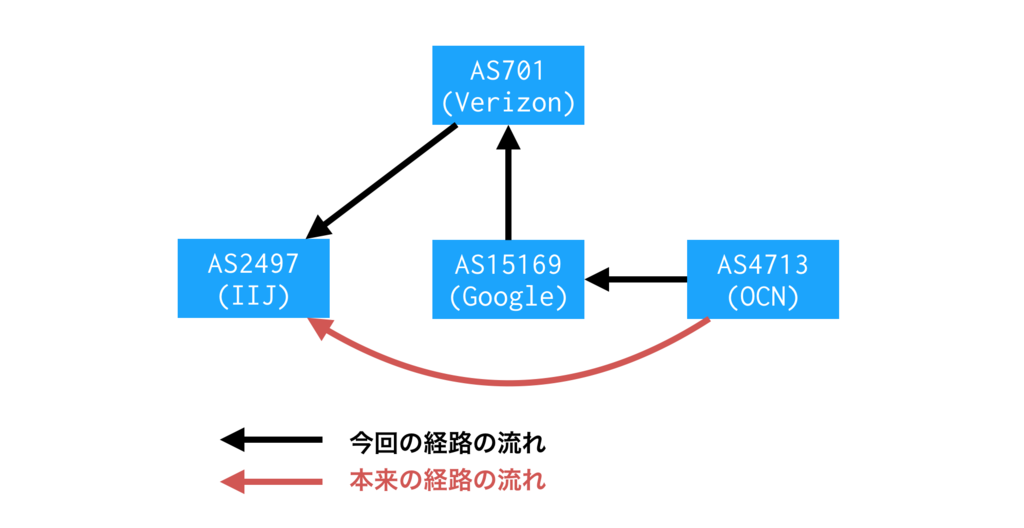

少しおかしいですね。AS4713 (OCN) がAS15169 (Google) を介してインターネット接続しているかのようなAS_PATH です。

AS15169 (Google) から見るとAS4713 (OCN) はピアであり、本来であればトランジットであるAS701 (Verizon) に経路広告するべきではありません。このような経路が10万あったということですね。

注: 正確に言えば広告しても構わないのですが、流れてくるトラフィックをさばける回線キャパシティを担保するべきです。

AS701 に流れた経路は、そのままAS2497 (IIJ) に流れます。では、AS2497 はその経路をベストパスとして選択し、パケット転送するでしょうか?

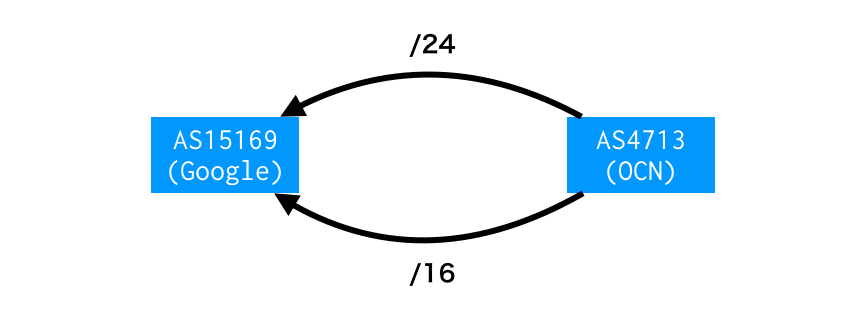

通常ならAS_PATH 勝負で負けるため この経路がベストになることはありませんが、実はこの経路 Prefix Length が違っていました。

route_leak=# SELECT masklen(prefix) AS len, count(distinct prefix) FROM updates WHERE ix='wide' AND neighbor_as=2497 AND aspath ='2497 701 15169 4713' GROUP BY len ORDER BY count DESC LIMIT 10; len | count -----+------- 24 | 16594 22 | 3035 23 | 2432 21 | 1764 20 | 868 19 | 79 16 | 29 18 | 15 17 | 10 15 | 3 (10 rows)

OCN クラスのISP であれば/12 ~ /20 くらいの大きなPrefix でルーティングすることが多いですが、障害中に観測された経路は/24 が大半です。Longest Match ルールにのっとってこの経路がベストになった、ということは容易に想像できます。

経路の中身について、ここまでまとめ

8/25 の障害時には、一例として AS2497 (IIJ) は「AS4713 (OCN) へのベストパスはAS15169 (Google) 経由」としていたことがMRT Dump から読み取れました。

ここからは想像ですが、10万経路ぶんのトラフィックがAS701、AS15169 に向かったため、

- 通信路のどこかで輻輳する

- 事業者の通信ポリシーによって通信が遮断される

- 遅延が増える (AS701、AS15169 は日本とは限らない)

ことが考えられます。

OCN と IIJ は一例であることに注意

ここまでIIJ → OCN 向きのトラフィックで説明しましたが、これは一例です。始点はIIJ に限らず、終点はOCN に限りません。アイボール側、コンテンツ側、どちらが影響を受けても通信が成り立たないことに注意です。

また、このエントリはMRT Dump を出発点にしています。限られた情報であり、障害時に起こっていた経路変化がすべてDump されているとは思えない = 見えていない影響も当然あると思われます。

大量の/24 はどこから来たか?

MRT Dump 上でみると、これら/24 のOrigin AS は4713 です。「4713 がOriginate した」と考えるのが自然です。

BGPMON の記事 でもそう考察されています。

ピアリング回線が複数あり、特定のトラフィックを特定の回線に乗せるためのトラフィックエンジニアリングですね。「経路はふつうAS15169 で止まるが、誤ってリークした」というのはありそうです。

いっぽう、AS4713 以外の事業者が生成している可能性ありそう、とも考えています。

「途中の事業者がPrefix を分割する」ようなケースです。ふつうはあまりやらないTE ですが、可能性を考えるためにAS15169 の右隣 != Origin AS なAS_PATH に注目してみましょう。観測されたAS_PATH のうち15169 より右を抜き出します。

route_leak=# SELECT substring(aspath from '15169.*') AS path, count(distinct prefix) FROM updates WHERE ix='wide' AND neighbor_as=2497 GROUP BY substring(aspath from '15169.*') ORDER BY count DESC LIMIT 10; path | count ------------------+------- 15169 4713 | 24831 15169 7029 | 7308 15169 8151 | 4639 15169 9121 | 4606 15169 9264 1659 | 3014 15169 9394 | 2129 15169 3209 | 1757 15169 7303 | 1580 15169 4230 28573 | 1475 15169 7545 | 1420 (10 rows)

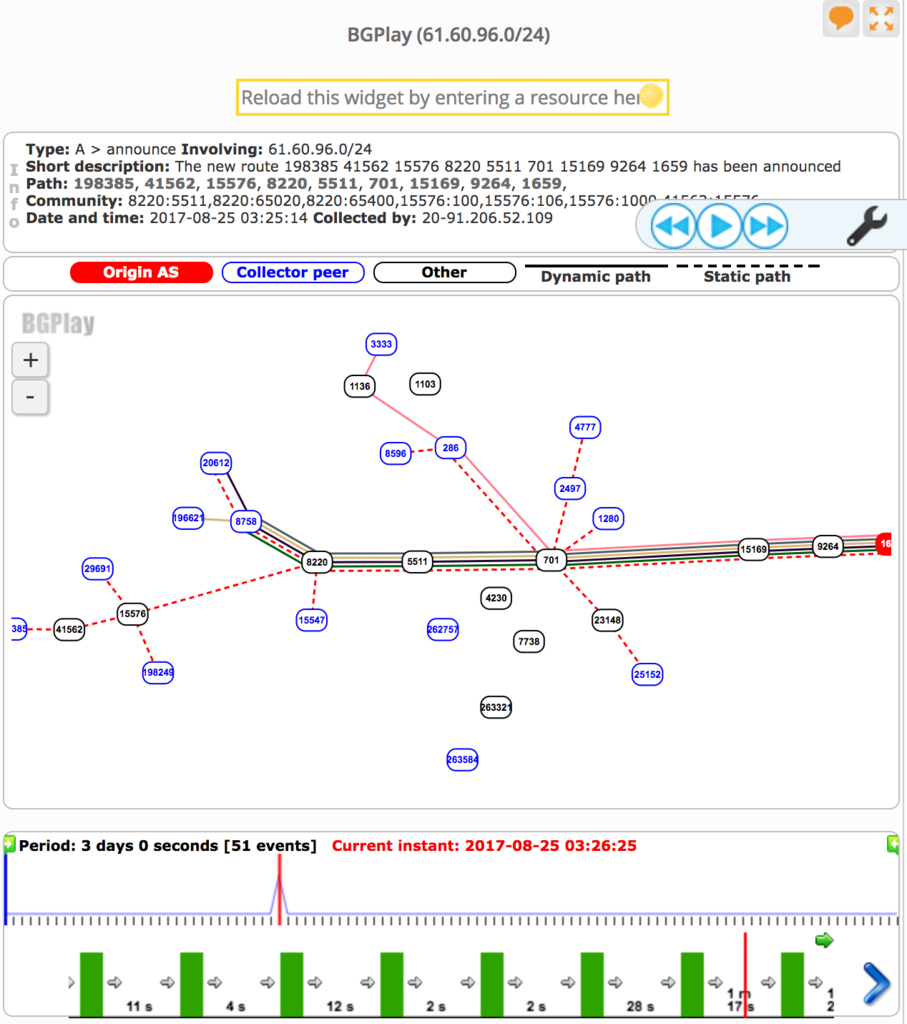

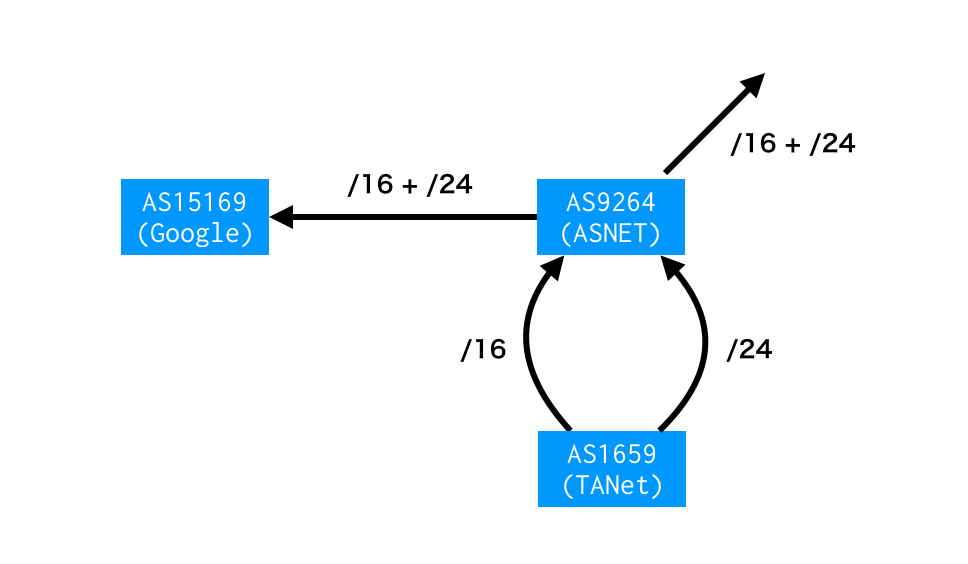

たとえば 15169 9264 1659。 Prefix でいうと61.60.96.0/24 など。

RIPEstat によれば、この経路は障害発生中にのみ存在しています。

あくまで想像の域を出ませんが、次のような可能性も考えられます。

経路だけをみれば、AS1659 (TANet) はAS9264 (ASNET) との間に複数回線もち、BGP によるTE を行なっているようです。この影響がAS15169 (Google) に漏れ聞こえ、インターネットに広告されているわけですが、この経路は障害のあった時間帯しか存在しません。

通常のルーティングとしては何か不自然です。AS9264 が他にも広告するためインターネットで常に観測されそうなのに、それがない。どちらかといえば、想像ですが「間の事業者が内部利用のために経路を生成した。それが漏れてしまった」と考えるほうがしっくりきます。

このように障害中のみ観測された経路、かなりの数あるようです。

海外に目を向ける

では、日本以外ではどうでしょう?

Route Views Project はグローバルにコレクターを配置しており、一部海外IX での経路変化を記録しています。

障害のあった期間中のBGP Update 総数を数えてみれば影響のあった事業者、なかった事業者のあたりをつけることができます。次のテーブル中で、count が小さいAS (neighbor_as) ほど影響が軽微だったと考えられます。

(count は観測されたBGP Update のユニークprefix 数、neighbor_as はRouteViews コレクターとピアしているneighbor AS )

route_leak=# SELECT ix, neighbor_as, count(distinct prefix) FROM updates GROUP BY ix, neighbor_addr, neighbor_as ORDER BY ix, count DESC; ix | neighbor_as | count ----------+-------------+-------- 3 | 286 | 101331 3 | 45352 | 5 3 | 134708 | 3 3 | 5645 | 3 3 | 6939 | 3 3 | 40387 | 3 4 | 45177 | 97396 4 | 48526 | 85617 4 | 38726 | 75787 4 | 34288 | 74560 4 | 36236 | 74365 4 | 24482 | 8 4 | 24516 | 7 4 | 24516 | 7 4 | 63956 | 5 4 | 38883 | 3 4 | 58682 | 3 4 | 58511 | 3 4 | 58511 | 3 4 | 58511 | 3 4 | 38726 | 3 4 | 1351 | 3 6 | 31019 | 100 6 | 53364 | 10 eqix | 3257 | 10 eqix | 41095 | 4 eqix | 11039 | 3 eqix | 6939 | 3 isc | 2497 | 114601 isc | 6939 | 3 linx | 41695 | 91612 linx | 34288 | 74560 linx | 37271 | 98 linx | 37271 | 98 linx | 58511 | 28 linx | 58511 | 28 linx | 3257 | 10 linx | 13030 | 5 linx | 13030 | 5 linx | 14537 | 4 linx | 6667 | 3 linx | 6939 | 3 linx | 37271 | 3 linx | 58511 | 3 linx | 37271 | 3 linx | 58511 | 3 nwax | 1798 | 98 nwax | 15301 | 3 nwax | 54073 | 3 oregon | 2497 | 114973 oregon | 286 | 101781 oregon | 701 | 98183 oregon | 7660 | 94091 oregon | 23673 | 8 oregon | 393406 | 7 oregon | 62567 | 7 oregon | 31019 | 5 oregon | 1221 | 5 oregon | 13030 | 5 oregon | 37100 | 4 oregon | 40191 | 4 oregon | 3303 | 4 oregon | 11686 | 4 oregon | 20912 | 3 oregon | 6762 | 3 oregon | 6939 | 3 oregon | 8492 | 3 oregon | 57463 | 3 oregon | 58511 | 3 oregon | 18106 | 3 oregon | 54728 | 3 oregon | 293 | 3 oregon | 47872 | 1 perth | 24516 | 5 saopaulo | 262757 | 93512 saopaulo | 53013 | 19034 saopaulo | 53013 | 18707 saopaulo | 262612 | 18692 saopaulo | 52863 | 16650 saopaulo | 28138 | 11 saopaulo | 52940 | 7 saopaulo | 28571 | 7 saopaulo | 262354 | 7 saopaulo | 262750 | 7 saopaulo | 52888 | 7 saopaulo | 264268 | 7 saopaulo | 263047 | 4 saopaulo | 52720 | 4 saopaulo | 1916 | 4 saopaulo | 262317 | 4 saopaulo | 26162 | 4 saopaulo | 263945 | 4 saopaulo | 26162 | 4 saopaulo | 26162 | 4 saopaulo | 28329 | 3 sfmix | 32212 | 73638 sg | 59318 | 69 sg | 24482 | 7 sg | 133165 | 5 sg | 24115 | 3 sg | 24115 | 3 sg | 38880 | 3 sg | 9902 | 3 sg | 18106 | 3 sydney | 58511 | 3 sydney | 4739 | 3 sydney | 38809 | 3 sydney | 4826 | 3 sydney | 38880 | 2 telxatl | 6082 | 3 telxatl | 53828 | 3 telxatl | 6939 | 3 wide | 2497 | 114965 wide | 7500 | 100240 (114 rows)

日本ほどの影響度は少数派ですね? それはなぜか?

よくわかりませんw

わかりませんが、障害トリガーとなった経路は「AS701 (Verizon) 経由でインターネットに流れた」と考えて差し支えなさそうです。観測されたAS_PATH のうち、15169 とすぐ左隣だけ抜き出します。

route_leak=# SELECT substring(aspath from '\d+ 15169') AS transit, count(distinct prefix) FROM updates GROUP BY transit ORDER BY count transit | count --------------+-------- 701 15169 | 162205 1798 15169 | 98 37271 15169 | 98 43531 15169 | 72 59318 15169 | 69 58511 15169 | 28 31019 15169 | 28 394625 15169 | 10 3257 15169 | 10 62567 15169 | 3 393406 15169 | 3 11492 15169 | 1 (12 rows)

では、AS15169 (Google) はAS701 にのみリークしたのか? もちろんその可能性は十分ありますが、もしそうではなく「他のトランジットにもリークしたが、そっちは問題にならなかった」のであれば学ぶべきポイントがありそうですよね。

普通、Tier1 プロバイダーは顧客向けBGP セッションに経路フィルターを設定します。多くの場合Peering DB やIRR から自動生成され、顧客が100% 制御できる かつオペミスを防げるようになっています。

- AS701 にはそれがなく、他のトランジット事業者にはあった

- AS701 にもあったが、特殊なアレンジをしていた。もしくは顧客がバイパスしていた

- 経路がピアを経由する際、うまくmax-prefix filter が効いた

いろいろ想像できますが、根拠がないため想像しても意味はなさそう。。。もし可能であればこのあたりのカラクリを知りたいもんです。

なぜこのエントリーを書いたか

できれば障害から学びたいと思ったからです。次に同じことが起こったとき、防げる気がしない。

BGP におけるネットワークが Autonomous System (自律システム) と呼ばれる通り、これまでのインターネットは各AS が自律的にルーティングすることでうまく動いてきました。隣のAS がミスをしたとき、できれば自分のところで影響を小さくして インターネット全体をなんとなく維持させたいと考えています。

そのために、ご近所さんのルーティングポリシーは可能な範囲で知っておきたい。最悪を想定するためでもあります。各事業者がビジネスでやっている以上「やめてほしい」は通らないかもですが、たぶん備えることはできます。

「BGP 脆弱やん」というご指摘はごもっともで、今後も同じシステムでインターネットを運用できるのかは怪しいです。しかしながら まだ打てる手はありそうで、「なぜ海外で問題なかったか」はヒントになりそうな…という感じがしています。*1

意外と「日本人マイクロマネージメントしすぎ」みたいな話題に流れていくかもしれません。

以上、「Postmortem 見たいです」のラブレターでした。

*1:Path Validation のようなハードル高い必殺技もあります